基于深度強化學習的人機協作組裝任務分配

時間:2022年03月09日 分類:教育論文 次數:

摘要:為適應人機協作組裝任務分配日趨復雜的任務結構和高維的任務狀態空間,提出了一種基于深度強化學習的人機協作組裝任務分配方法。首先,將人機協作組裝任務分配形式化為強化學習問題,設計了通道幀圖進行任務分配環境狀態的表示,并構建了通用化的組裝闖關游戲模擬環境。其次,為解決DQN(DeepQNetworks)算法頻繁的情節重啟導致探索效率低下的問題,提出了存檔機制及其改進算法ArchiveDDQN(DoubleDQN),并介紹了利用該算法與模擬環境交互以進行人機協作組裝任務分配的流程方法。最后,通過種不同難度的組裝模擬環境進行對比實驗,驗證了所提出方法的有效性。

關鍵詞:深度強化學習;存檔機制;人機協作;任務分配;生產組裝

0引言

自1990年以來,制造業中的人機協作(RC,Humanrobotcollaboration)得到了廣泛的研究和關注[14]。工業4.0的推行,人機協作成為制造業中主要的網絡物理技術和促成技術之一[5,6],利用人機協作的工業應用數量迅速增長7]。其中,組裝是人機協作最有趣和最有前景的應用場景之一8]。在人機協作組裝的工業設計中,任務分配決定著人和機器人的工作內容和執行順序,深刻影響著人機協作的流暢性和生產系統的效率,是當前學界研究的熱點之一。傳統的人機協作組裝任務分配方法通常將問題形式化為帶約束的組合優化問題,并通過算法進行優化以實現特定目標利益的最大化10。

LAMON等11以任務復雜性、靈巧性和工作量為組合指標,提出了一種離線分配算法,可以將任務最佳地分配給工作單元,并在金屬結構的概念協作組裝中進行了驗證。WANG等12設計了包含時間消耗和人工的協作成本函數,并開發了啟發式行動計劃算法優化成本函數,從而生成最優的組裝任務分配方案。JOHANNSMEIER等13將人和機器人的差異特殊性轉移到不同的成本函數中,并基于方法定義了一種啟發式算法優化人機協作組裝成本。

孔繁森等14以資源利用均衡率、工人操作復雜度均衡率、平均決策過程復雜度為約束條件,以最小化平衡滯延時間為目標,并使用遺傳算法優化得到人機協作組裝任務分配最佳方案。傳統的組合優化方法主要針對簡單的任務結構和極小的任務空間,并未考慮人和機器人均可執行的操作,缺乏靈活性和通用性。隨著人機協作技術的發展,組裝任務的結構將變得愈加復雜(如人機并行執行共享任務),任務空間也愈加龐大(如多個工人和多個機器人)。在充分考慮必要的人和機器人信息以及組裝約束條件下,人機協作組裝任務分配將具有高維復雜的狀態空間,這是傳統的組合優化方法難以解決的。近年來,隨著物聯網(IOT,InternetofThings)的發展,大數據處理方法如廣域存儲與計算協同調度15、移動邊緣計算16等有利于實現更高效率的大規模人機協作組裝任務分配。

值得注意的是,深度學習和強化學習技術在處理高維復雜空間問題和大規模決策問題上表現出日益顯著的優勢,為克服傳統任務分配方法的局限性提供了新的方向。如ZHEYUAN等[17]開發了一種新的基于深度圖注意網絡的分配算法來自動學習分配問題的特征,在測試中約的任務分配問題找到了高質量的任務分配方案。等[18]通過將人機協作組裝過程格式化為具有映射規則和游戲規則的組裝棋盤,并使用基于強化學習的自演算算法實現了可調節高度的辦公桌組裝案例的最佳任務分配。

隨后,在組裝棋盤的基礎上,等[19]采用基于深度強化學習算法DQN(DeepQNetworks)的多智能體強化學習MARLMultigenteinforcementearning方法求解任務分配策略,并通過組裝案例驗證了該方法在不同任務數和智能體數下的有效性。受上述研究的啟發,結合華晨寶馬搭建智能白車身生產系統的項目需求,本文提出了一種基于深度強化學習的人機協作組裝任務分配方法。

本文首先將人機協作組裝任務進行問題建模,并構建闖關游戲形式的通用化強化學習求解環境。區別于文獻18]和19]的組裝棋盤,本文設計了通道幀圖來表示任務分配的環境狀態,這種格式不僅能更清晰地反映高維復雜任務分配環境的狀態信息,而且可以直接轉化為數字張量輸入到深度神經網絡以便于深度強化學習算法的求解。在該組裝闖關游戲模擬環境中,DQN系列算法可以在沒有任何指導的情況下從初始狀態開始執行任務分配動作。然而,在訓練過程中,現有的DQN算法容易遭遇錯誤動作,導致頻繁的情節重啟。在實現完整的任務分配之前,算法容易陷入困境。因此,本文開發了存檔機制,以提升算法的探索效率并改善經驗池回放基準。同時,本文還提供了存檔機制的兩種應用模式及其改進算法ArchiveDDQN,以進一步提升算法的性能,實現更高效的人機協作組裝任務分配。

1.人機協作組裝任務分配問題建模

1.1問題描述

人機協組裝作任務通常可以按照三個主要步驟進行實施。首先是任務分解,即將一個組裝任務拆分成一定數量的子任務。其次是任務排序,根據實際的需求和約束等將子任務按照一定的先后順序進行排列。最后也是最關鍵的是任務分配,需要根據子任務特征來進行工作負荷分配,以充分發揮工人和協作機器人的各自優勢,提高生產效率。在華晨寶馬搭建智能白車身生產系統這一項目中,需要在項目前期自動生成最優的人機協作組裝任務分配序列,為人機協作生產工位的快速布置和規劃提供指導。為了清晰地描述人機協作組裝任務過程,使用該項目中一組前端模塊支架的人機協作組裝任務進行演示。

(1)任務分解。該組裝任務的目的是通過前表面和上表面的螺栓組(由螺栓和墊片組成)來連接支架零件。前表面朝上時,先放置個螺栓組(B1~B4),然后擰緊螺栓。接著通過翻轉使上表面朝上,工作內容與前表面一致。該任務被分解為18個子任務,如表所示。根據任務的物理特性和工作單元的操作特性,子任務可以分為三種類型,類(僅適合人),類II(僅適合機器人),類III(通用型任務,適合人和機器人)。例如,人可以輕松地拾取螺栓組合,并精準地將螺栓旋入帶螺紋的孔中。

但是,這個任務對于機器人來說可能需要花費非常高昂的代價。類似的,使用機器人擰緊螺栓速度更快且可以保證穩定的預緊力。此外,有些任務是通用的,如翻轉支架沒有太高的約束要求,分配給人和機器人都是可以的。值得一提的是,這類通用型的任務分配給人或者機器人的執行時間可能是不一樣的。因此,可將時間項按工作單元類型進行劃分。

(2)任務排序。對于組裝任務,其子任務的執行順序是受組裝條件限制的,如產品設計、質量控制、物理約束等。因此,有些子任務之間存在順序約束。例如,必須先放置了螺栓組合才可以去擰緊。相反,有些子任務之間沒有順序約束,如先放置哪個螺栓組合。此外,放置完一個螺栓組合就立即執行擰緊操作也是允許的。為了規范組裝順序,在本案例中,將同一個工作面上的所有螺栓組合放置好之后再執行擰緊操作。為了清晰地表述子任務之間的順序約束,設計了關系聯絡矩陣。其中,第一行和第一列為子任務的編號。編號

(3)任務分配。一般而言,任務排序受到的限制條件是相對寬松的,這意味著子任務的具體執行順序存在很多可能性。這無疑增加了任務分配的難度。同時,任務分配還要考慮子任務的屬性和工作單元的負載平衡,以實現最大化的工作效率。其中很重要的一點就是決定通用型任務到底分配給人還是機器人更合適。

1.2形式化強化學習

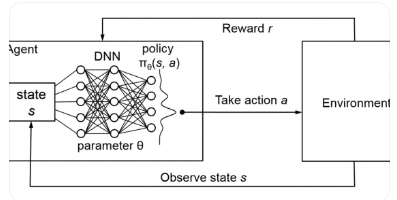

將人機協作組裝任務分配形式化為一般的強化學習,可以為問題求解提供極大的便利。

2以存檔機制改進的算法ArchiveDDQN

2.1存檔機制及其原理

在深度強化學習算法中,由MNIH等20,2提出的DQN算法,在處理高維的狀態空間問題上展現出巨大的優勢。近年來,DQN得到了極大的改進和拓展[2,在多種Atati游戲中都取得了超越人類平均水平的成績。在人機協作組裝闖關游戲環境中,DQN系列算法可以從零開始通過不斷自學習獲得最優的任務分配策略從而完成闖關游戲。但在訓練的早期階段,由于QN深度近似網絡權重參數初始化的隨機性和深度近似網絡擬合能力的不確定性,算法十分容易產生錯誤的分配動作,導致闖關失敗從而使游戲情節頻繁重啟。現實中的許多闖關游戲都設置了功能選項進行存檔,在終結或者中途退出后,游戲可以通過重載存檔繼續進行。

2.2存檔機制應用模式及其改進算法

根據存檔機制的特點,本文提出了兩種存檔機制的應用模式,分別是普通模式存檔機制(Archiveormalmode,Archive)和通關模式存檔機制(rchiverushmod,Archive)。顧名思義,普通模式就是在

此外,通關模式存檔機制Archive能保證所有子任務均能得到分配,避免了任務分配失敗。VANHASSELT等人25改進的DoubleDQN(DDQN)學習算法,通過兩個網絡分別進行學習解決了學習中因最大化偏置導致的狀態值被過度估計的問題。因此,本文在DQN的基礎上,提出了以存檔機制改進的算法ArchiveDQN。

3利用ArchiveDDQN進行任務分配

3.1ArchiveDDQN算法訓練和測試

在獲取人機協作組裝任務分配策略和最優方案之前,需要使用人機協作組裝闖關游戲模擬環境對ArchiveDDQN算法的智能體進行訓練和測試。

在訓練過程中,組裝闖關游戲模擬環境和ArchiveDDQN算法之間需要進行實時交互。首先,執行環境將環境狀態輸出,并轉換為張量輸入到算法的近似網絡。算法智能體得出分配動作后由模擬環境執行分配動作,然后輸出新的環境狀態和獎勵。然后對每一次獲得的分配動作、環境狀態和獎勵進行統一格式并存入經驗池。最后通過小批量隨機采樣抽取經驗池中的經驗數據對智能體進行訓練,從而不斷改進智能體的任務分配策略。在進行測試時,需要先獲取訓練過程得到的深度網絡權重參數,然后加載到深度近似網絡。與訓練過程不同的是,測試過程不進行經驗回放和小批量采樣訓練,智能體的任務分配策略是固定不變的。

3.2獲取最優任務分配策略和分配方案

通過訓練和測試對比,可以獲得最優的任務分配策略。在應用ArchiveDDQN算法進行人機協作組裝任務分配時,只需將最優任務分配策略對應的深度網絡權重參數加載到算法的深度近似網絡即可。

在任務分配過程中,組裝闖關游戲模擬環境與ArchiveDDQN算法是實時交互的,面對任意的模擬環境狀態,ArchiveDDQN算法均能以最優任務分配策略輕松獲得下一步的最優任務分配動作,這對于拓展到動態任務分配是十分有利的。通過整理模擬環境和算法的輸出信息,可快速獲得最優任務分配方案。組裝闖關游戲模擬環境與ArchiveDDQN算法之間的交互是按情節劃分的,通過將單一情節的分配動作依次排序即可得到該情節的任務分配工作序列,由獎勵功能定義可知,累積獎勵最大的工作序列具有最短的工作時長,為最優任務分配方案。

4實驗與討論

為了驗證任務分配環境以及所提出改進算法的有效性,我們在兩個不同難度的分配任務中,對DQN和存檔機制改進算法ArchiveDDQN(rchiveDQN和ArchiveRDQN)進行了訓練和測試。實驗中,三種算法均使用文獻[2提供的深度神經網絡,通過兩個網絡分別學習目標函數。

5結束語

本文提出了一種基于深度強化學習的人機協作組裝任務分配方法,以適應人機協作任務分配日趨復雜的任務結構和高維的任務空間。本文的貢獻和創新點主要有兩點:

(1)將人機協作組裝任務分配形式化為強化學習問題,并構建了通用化的組裝闖關游戲模擬環境,使得高維復雜的任務分配問題可以便捷地使用深度強化學習方法進行求解;(2)提出了存檔機制及其改進算法ArchiveDDQN,解決了傳統DQN系列算法情節頻繁重啟的問題,進一步提升了算法的性能和人機協作組裝任務分配的穩定性。在兩種不同難度的實驗環境中,普通模式存檔機制均能有效提升DQN算法的訓練速度和訓練效果。

在通關模式下,存檔機制得到了更好的發揮,使得DQN算法獲得了優秀的全局探索能力和測試穩定性。實驗證明了所提出的人機協作組裝任務分配方法的有效性。在未來的工作中,將考慮更復雜的場景,如多個組裝任務的混合執行和人類行為的不確定性等。在進一步拓展所提出算法工業應用的同時,將考慮采用更先進的技術去減少計算量和提升訓練效率。

參考文獻:

[1]ROBLAGOMEZS,BECERRAVM,LLATAJR,etal.Workingtogether:Areviewonsafehumanrobotcollaborationinindustrialenvironments[J].IEEEAccess,2017,5:2675426773.

[2]WANGL,GAOR,VANCZAJ,etal.Symbiotichumanrobotcollaborativeassembly[J].CIRPAnnalsManufacturingTechnology,2019,68(2):701726.

[3]ZACHARAKIA,KOSTAVELISI,GASTERATOSA,etal.Safetyboundsinhumanrobotinteraction:Asurvey[J].SafetyScience,2020,127:104667.

[4]LIHao,LIUGen,WENXiaoyu,etal.Industrialsafetycontrolsystemandkeytechnologiesofdigitaltwinsystemorientedtohumanmachineinteraction[J].ComputerIntegratedManufacturingSystems,2021,27(2):16(inChinese).[李浩,劉根,文笑雨等.面向人機交互的數字孿生系統工業安全控制體系與關鍵技術[J].計算機集成制造系統,2021,27(2):16.]

[5]SARA,JENSEN.TheIndustrialInternetofThings[J].OEMOffHighway,2016,34(7):2022.

作者:熊志華1,陳昊2,王長生1,岳明1,侯文彬1,3,+,徐斌2

SCI論文

- 2025-03-08一篇SCI/SSCI論文從投稿到錄用最

- 2025-03-08SCI論文投稿格式要求有哪些?查收

- 2025-03-07Journal of Cleaner Production

SSCI論文

- 2025-02-28新聞傳播研究專業英文論文可選的

- 2025-02-19Cogent Education期刊分區和影響

- 2025-02-10經管專業快速發表ssci論文的做法

EI論文

- 2025-03-05EI會議在哪發論文,解答及指導

- 2025-03-01EI會議論文值得發嗎?2025EI會議

- 2025-02-28EI會議論文在國內算哪個級別

SCOPUS

- 2025-02-07什么是全文型數據庫?scopus數據

- 2025-01-24scopus發表文章格式修改指南

- 2024-11-19Scopus收錄的建筑工程類期刊

翻譯潤色

- 2024-11-22國際中文期刊發表論文應該用什么

- 2024-11-22國際中文教師能在國際中文期刊發

- 2024-11-22國際中文期刊評職稱承認嗎

期刊知識

- 2025-03-08面對北大核心、南大核心、SCI、S

- 2025-03-072025年北大核心的最新目錄是哪一

- 2025-03-06中國社會科學投稿用郵箱還是投稿

發表指導

- 2025-03-07中西醫結合、康復相關方向論文范

- 2025-03-07精選中西醫結合、康復相關方向選

- 2025-03-06圍繞制藥企業可寫的論文選題